Stress lavoro correlato nell’ASST di Lodi: analisi dei dati del 2015

Stress lavoro correlato: A seguito dell’approvazione del Testo Unico 81 del 2008 (art.28), la tematica “stress” è diventata sempre più protagonista della Sicurezza sul Lavoro.

In questo scenario, l’ASST di Lodi ha attivato programmi di Prevenzione dello Stress lavoro correlato attraverso visite psicologiche preventive per i neo-assunti e di sostegno psicologico.

I. Cacciatori, C. Grossi , S. Marazzina

U.S.S.D. Psicologia Clinica, Dipartimento Salute Mentale, Azienda Socio Sanitaria Territoriale (ASST) di Lodi – Area di Psicologia del Lavoro

Abstract

Durante queste visite oltre all’anamnesi personale e lavorativa vengono somministrati dei test volti a fornire indicatori della presenza di eventuali fattori di rischio psicosociale, burnout e stress lavoro correlato.

I dati del presente articolo riportano una descrizione di quanto raccolto dai referti effettuati nell’anno 2015, da cui è emersa una differenza relativa al genere ed all’età, una differenza nel numero di prime visite e di visite a richiesta in fasce d’età di 10 anni, riportando dati significativi a riguardo. E’ stata fatta inoltre una suddivisione per visualizzare il numero di colloqui di cui hanno avuto bisogno pazienti inviati dal Medico Competente.

Le analisi dei dati hanno inoltre riportato una classificazione dei test maggiormente utilizzati, cui fa capo la Resilience Scale e la percentuale di soggetti che si sono mostrati resilienti e quanti a rischio di burnout, analizzando nello specifico le varie sottoscale del MBI.

Infine è stata valutata la percentuale di soggetti a cui è stato indicato un trasferimento e quanti invece hanno concluso con un percorso di counselling, evidenziando così l’efficacia del processo.

Introduzione: lo stress lavoro correlato

L’interesse per lo stress e per le sue manifestazioni è andato gradualmente crescendo nel corso degli ultimi trent’anni.

In tutti i settori lavorativi e nell’ambito di alcuni governi Nazionali, si è verificata una crescente convinzione che l’esperienza dello stress nella vita moderna, come sul lavoro, ha delle conseguenze indesiderate per la salute e la sicurezza degli individui nonché per la salute delle organizzazioni o degli ambienti sociali (Ferrari, 2012).

L’Agenzia Europea per la Sicurezza e la Salute nel Lavoro definisce lo stress lavoro correlato come [blockquote style=”1″]la percezione di squilibrio avvertita dal lavoratore quando le richieste del contenuto, dell’organizzazione e dell’ambiente di lavoro eccedono le capacità individuali per fronteggiare tali richieste.[/blockquote]

Tale condizione, determinata da fattori legati al contesto lavorativo, alle attività svolte e all’organizzazione del lavoro, ha conseguenze non solo sul benessere dell’individuo (patologie cardiovascolari, immunitarie, gastrointestinali, ecc.), ma anche sul benessere dell’azienda in cui esso lavora.

Successivamente all’approvazione del Testo Unico 81 del 2008 (articolo 28), la tematica è diventata sempre più protagonista nella Sicurezza sul Lavoro.

Il rischio da Stress Lavoro Correlato interessa tutte quelle figure caricate da una duplice fonte di stress: personale e della persona oggetto d’aiuto. Esso in particolare colpisce i medici e le altre figure sanitarie, compresi volontari e studenti, gli addetti ai servizi di emergenza, tra cui poliziotti e vigili del fuoco, psicologi, psichiatri e assistenti sociali, sacerdoti e religiosi, insegnanti ed educatori, avvocati e ricercatori.

In questi soggetti, se non opportunamente seguiti, può iniziare a svilupparsi un lento processo di “logoramento” o “decadenza” psicofisica dovuta alla mancanza di energie e di capacità per sostenere e scaricare lo stress accumulato (burnout).

Il burnout comporta esaurimento emotivo, depersonalizzazione, un atteggiamento spesso improntato al cinismo e un sentimento di ridotta realizzazione personale. Il soggetto tende a sfuggire l’ambiente lavorativo assentandosi sempre più spesso e lavorando con minor entusiasmo ed interesse, a prova della frustrazione e insoddisfazione, nonché una ridotta empatia nei confronti delle persone delle quali dovrebbe occuparsi. Il burnout si accompagna spesso ad un deterioramento del benessere fisico, a sintomi psicosomatici come l’insonnia e psicologici come la depressione. I disagi si avvertono dapprima nel campo professionale, ma poi vengono con facilità trasportati sul piano personale: l’abuso di alcol, di sostanze psicoattive ed il rischio di suicidio sono elevati nei soggetti affetti da burnout (Tomei et. al., 2013).

E’ importante raccogliere quindi una serie complessa di informazioni sulla qualità di vita e di lavoro della persona per poterne fare una valutazione omogenea riguardante la condizione psicologica legata allo stress lavoro correlato, quali: informazioni sulla sua condotta al lavoro (assenteismo, cambio di mansione o assenza per malattia); l’ambiente di lavoro nel quale opera, quali sono i rischi legati alle mansioni svolte; il rapporto con i colleghi e con i superiori nel posto di lavoro; le strutture relazionali fuori dal contesto lavorativo; le aspettative di realizzazione personale legate a quella determinata occupazione e la gratificazione che da essa ne deriva.

Prevenzione dello stress lavoro correlato e sostegno psicologico nell’ASST di Lodi

L’ASST di Lodi ha attivato programmi di Prevenzione dello Stress lavoro correlato attraverso il supporto dell’U.S.S.D Psicologia Clinica-Area di Psicologia del lavoro e dell’organizzazione.

I dati che saranno presentati in seguito riguardano nello specifico le visite psicologiche effettuate dal servizio di Psicologia del lavoro nell’anno 2015 suddivise in preventive per i neo-assunti e di sostegno psicologico per i già dipendenti dell’Azienda.

Nel primo caso, il nuovo dipendente viene inviato ed invitato dal medico competente dell’ASST ad effettuare un colloquio psicologico finalizzato a rilevare eventuali fattori di vulnerabilità e/o di rischio legati alla mansione e fornire informazioni inerenti la gestione del rischio da stress lavoro correlato.

Nel secondo caso, invece, si offre ai lavoratori un supporto psicologico volto a sostenere il dipendente in situazioni di difficoltà lavorative a diversi livelli.

I soggetti: dati strutturali

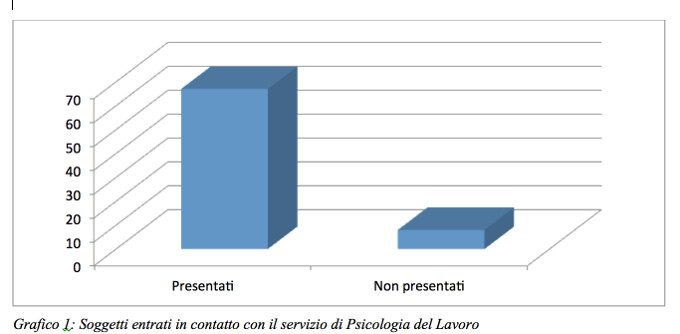

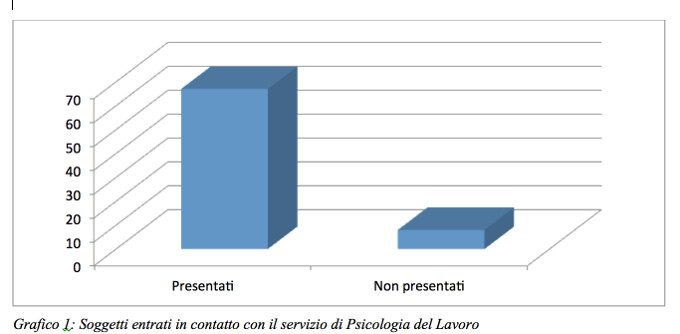

Nell’anno 2015 sono entrati in contatto con il servizio di Psicologia del lavoro 75 soggetti, quasi il doppio rispetto al 2014, che ne registrava 40. Di questi 75 si sono presentati fisicamente presso il nostro ufficio 67 casi (vedi grafico 1).

Grafico 1: Soggetti entrati in contatto con il servizio di Psicologia del Lavoro

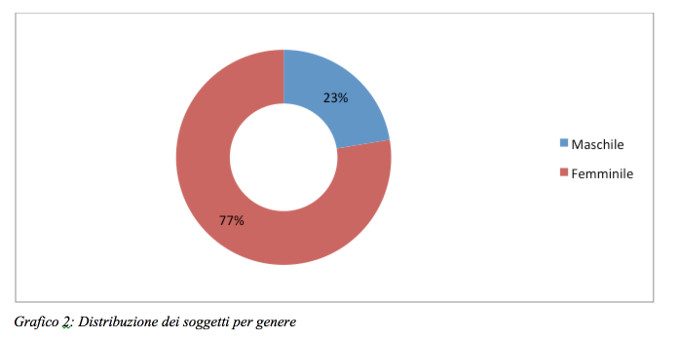

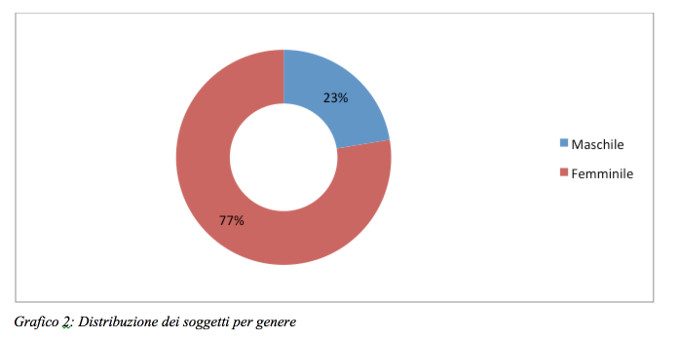

Come evidenziato dal grafico 2 sotto riportato, la distribuzione secondo il genere di coloro che si sono presentati rileva una consistente maggioranza del genere femminile (52 casi) con una percentuale sul campione pari al 77% dei casi.

Grafico 2: Distribuzione dei soggetti per genere

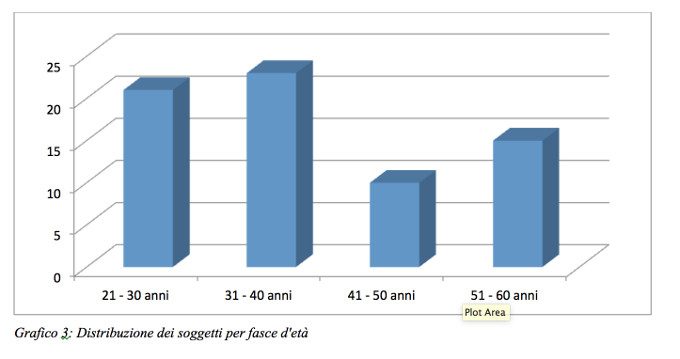

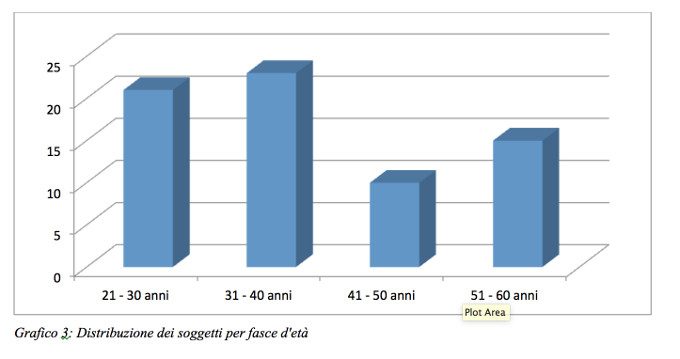

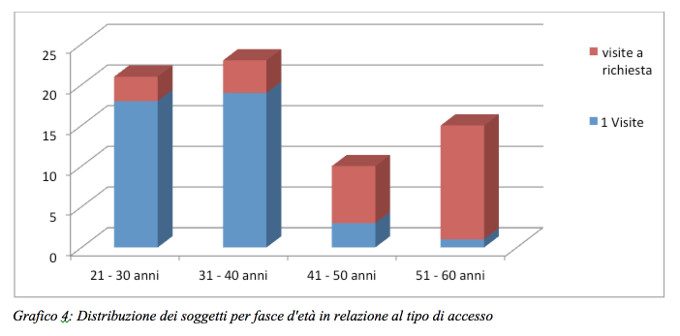

I dipendenti hanno un’età compresa tra i 21 e i 60 anni ed emerge una chiara collocazione prevalente nelle fasce inferiori ai 40 (di 7 soggetti il dato non è pervenuto).

Il grafico 3 riporta la distribuzione dei soggetti per fasce di età, comprendenti ciascuna un range di 10 anni.

Grafico 3: Distribuzione dei soggetti per fasce d’età

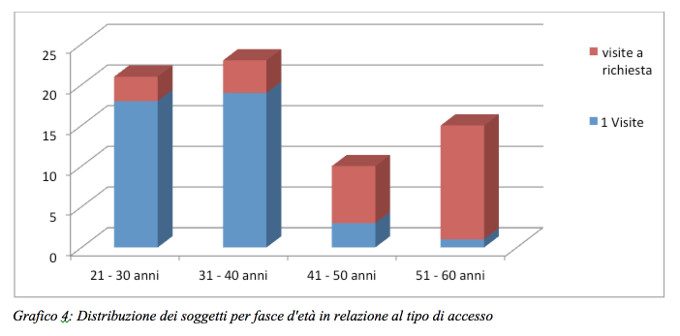

E’ stata effettuata un’ulteriore suddivisione del campione, in relazione all’accesso a questo ambulatorio:

prime visite, di esclusiva pertinenza dell’ufficio di psicologia del lavoro

visite a richiesta, che comprende i dipendenti inviati sotto suggerimento del medico competente, gli accessi spontanei e coloro che sono stati inviati dal responsabile della Unità Operativa, i quali vengono sottoposti all’attenzione del servizio di counselling psicologico presso l’ufficio di psicologia clinica a cui fa capo la dottoressa Ivana Cacciatori.

Come si vede dal grafico 4, si è riscontrata una percentuale significativa di prime visite tra i 21 e i 40 anni, mentre una percentuale significativa di visite a richiesta è stata riscontrata nella fascia d’età che va dai 41 ai 60 anni, con progressivo aumento tra i 51 e 60.

Grafico 4: Distribuzione dei soggetti per fasce d’età in relazione al tipo di accesso

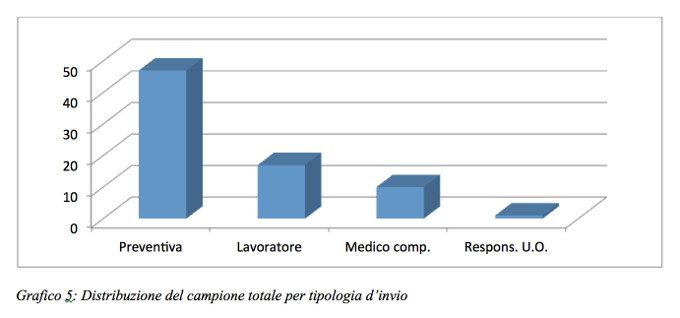

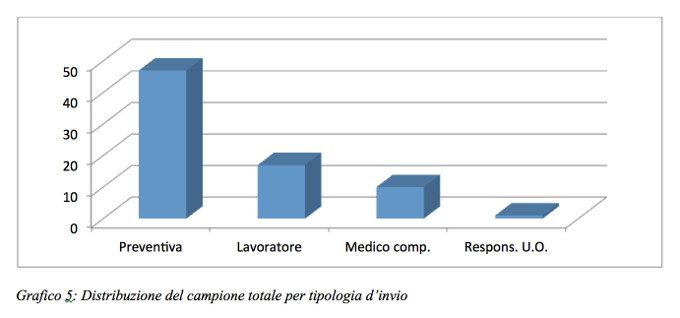

Sul totale dei soggetti, osservando le percentuali nel grafico sotto riportato, la maggior parte, il 63%, si sono presentati per una visita preventiva come neo-assunti, il 23% hanno richiesto la visita personalmente, il 13% è stato inviato dal medico competente e l’1% è stato inviato sotto suggerimento del responsabile della propria Unità Operativa. Nessun soggetto si è presentato per una visita a richiesta del Responsabile dell’U.O. in cui lavora (grafico 5).

Grafico 5: Distribuzione del campione totale per tipologia d’invio

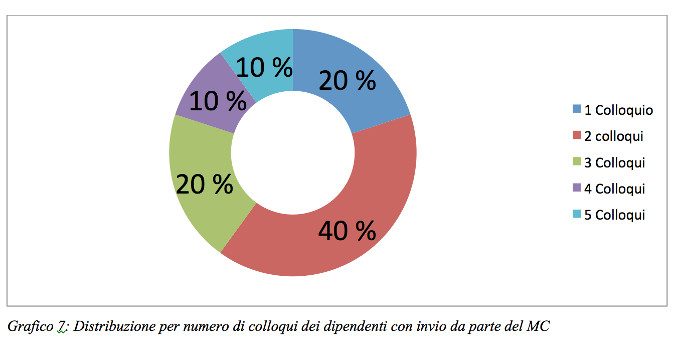

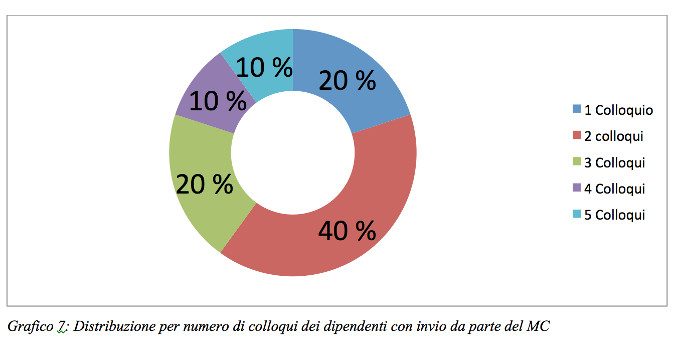

Sono stati valutati inoltre il numero di colloqui a cui sono stati sottoposti i dipendenti giunti al nostro ambulatorio tramite invio da parte del medico competente (vedi grafico 7).

L’analisi dei dati riporta una maggioranza significativa per 2 colloqui.

Grafico 7: Distribuzione per numero di colloqui dei dipendenti con invio da parte del MC

Dati relativi ai test somministrati

Sia durante le visite preventive che durante quelle a richiesta del lavoratore/medico competente/responsabile U.O. possono essere somministrati ai soggetti dei test volti a fornire indicatori della presenza di eventuali fattori di rischio psicosociale, burnout e stress lavoro correlato.

I test utilizzati nel servizio di Psicologia del lavoro sono i seguenti:

Resilience Scale (Wagnild and Young) – Scala della Resilienza

MBI – Maslach Burnout Inventory

TAS – Toronto Alexithymia Scale

Test di Ferrari e Sinibaldi

BPI – Burnout Potential Inventory

WSRQ – Work Stress Risk Questionnaire

ProQUOL – Professional Quality of Life

Beck Depression Inventory

ASQ – Anxiety Scale Questionnaire (Scala d’ansia IPAT)

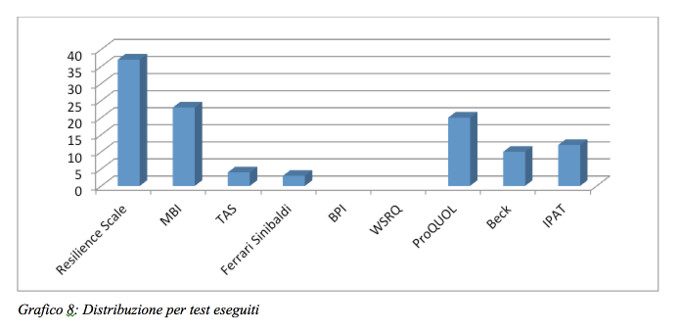

Bisogna considerare che il test, in qualità di strumento diagnostico ed in relazione alle sue specificità, è stato e viene tutt’ora somministrato a discrezione dello psicologo che si occupa di diagnosi, nella misura e con la frequenza necessari ad individuare le peculiarità di interesse clinico: proprio in ragione di questa specificità e singolarità nella funzione diagnostica, alcuni soggetti possono essere stati esclusi dalla somministrazione di tali strumenti, mentre altri pazienti possono essere stati sottoposti a più prove testistiche.

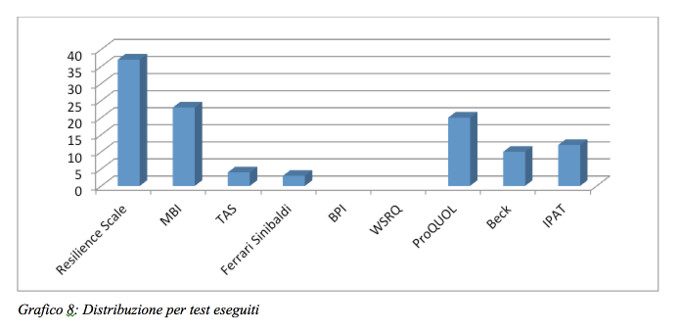

Ne emerge un quadro complessivo variegato che conta un numero totale di test eseguiti pari a 109 distribuiti come segue

Grafico 8: Distribuzione per test eseguiti

Appare immediatamente evidente come la scala che misura la resilienza (Resilience Scale di Wagnild e Young) appaia come la più somministrata.

Resilience Scale di Wagnild e Young

Scala di autovalutazione elaborata da Wagnild e Young nel 1993, con lo scopo di misurare la resilienza disposizionale negli adulti.

La resilienza è il processo di fronteggiamento e superamento degli effetti legati all’esposizione a fattori di rischio o eventi traumatici. Viene vista come la capacità dell’uomo di affrontare le avversità della vita, di superarle e di uscirne rinforzato e addirittura trasformato positivamente. La versione del test somministrata presso l’ufficio di Psicologia del Lavoro consta di 10 item, con scala Likert a 7 punti (1 “fortemente in disaccordo”;7 “pienamente in accordo”).

Interpretazione dei risultati del test

I punteggi hanno un range che va da 10 a 70, suddiviso nelle seguenti categorie:

Resilienti (con un punteggio uguale o maggiore di 59)

Mediamente resilienti (con un punteggio tra 48 e 58)

Non resilienti (con un punteggio inferiore o uguale a 47)

Le persone resilienti sono capaci di adattarsi e resistere di fronte alle difficoltà, hanno una buona capacità di mantenere il controllo, di attuare strategie di coping e ricerca di risorse ambientali per fare fronte alle sfide della vita. Le persone mediamente resilienti sono generalmente in grado di fare fronte ad eventi stressanti; risentono tuttavia della qualità e della quantità di questi eventi e di conseguenza riescono ad affrontarli con una varietà di modi non sempre perfettamente e propriamente adattivi. Le persone non resilienti sono invece quelle persone che generalmente soccombono di fronte alle difficoltà.

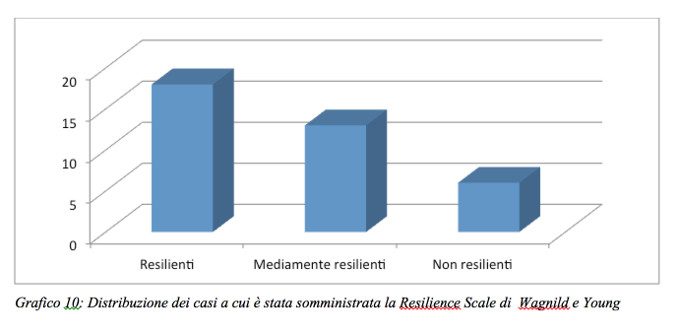

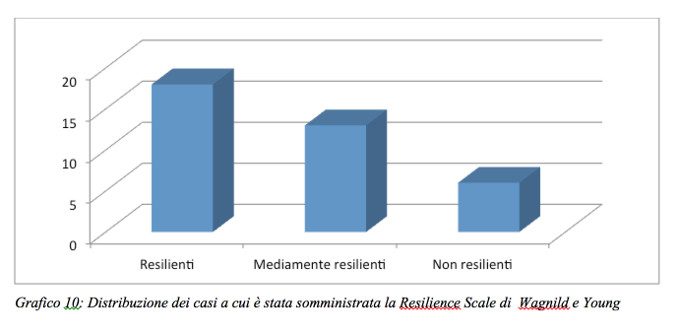

Dalle rilevazioni testistiche nell’arco del 2015 i dati relativi alla resilienza dei casi analizzati attraverso la Resilience Scale di Wagnild e Young emerge quanto segue:

resilienti il 49%

mediamente resilienti il 35%

non resilienti il 16%

Grafico 10: Distribuzione dei casi a cui è stata somministrata la Resilience Scale di Wagnild e Young

Maslach Bornout Inventory

Si tratta di un questionario sviluppato nel 1981 da Maslach e Jackson e composto da 22 items, volti a stabilire se nell’individuo sono attive dinamiche psicofisiche che rientrano nel burnout. Ad ogni domanda, il soggetto deve rispondere segnando un valore da 0 a 6 per indicare l’intensità e frequenza con cui si verificano le sensazioni descritte nella domanda stessa.

Esso affronta tre diversi campi della professionalità:

esaurimento emotivo

depersonalizzazione

gratificazione personale.

Esaurimento emotivo: la dimensione attinente alla sfera del sentire: il soggetto si sente sfinito, svuotato dal punto di vista emozionale, senza più forza per ricominciare. Le sue risorse emozionali sono consumate e non c’è modo di reintegrarle. La sensazione del soggetto è quella di aver oltrepassato i limiti, di aver esaurito le proprie energie psicologiche, senza una sorgente da cui poter attingere. La persona si sente incapace di rilassarsi e recuperare, sente che non ha più energie da spendere per l’altro (Maslach & Leiter, 2012).

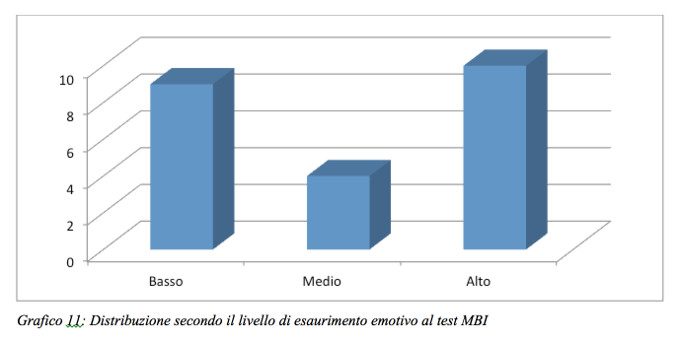

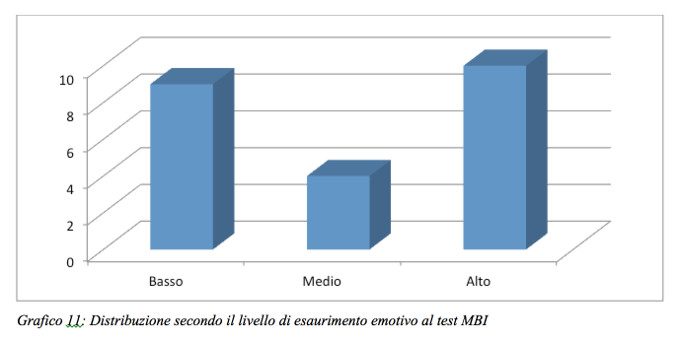

Come evidenziato nel grafico 11, il 40% dei soggetti presenta un livello di esaurimento emotivo basso, mentre il 43% di loro presenta un livello di esaurimento emotivo alto.

Livello di esaurimento emotivo medio è stato riscontrato nel 17% dei casi.

Grafico 11: Distribuzione secondo il livello di esaurimento emotivo al test MBI

Depersonalizzazione: è la dimensione attinente alla sfera interpersonale: il soggetto “esaurito” non ha più energia disponibile per l’aiuto all’utente. Perciò gradualmente si ritira dalla relazione, instaurando un atteggiamento di indifferenza/insofferenza verso i bisogni degli altri ed un cinico disinteresse verso i loro sentimenti. Come conseguenza spesso si sviluppa un senso di colpa e un disconoscimento di sé da parte dell’operatore che vede nel suo comportamento rinnegate le motivazioni iniziali che l’avevano spinto a scegliere proprio quella professione (Maslach & Leiter, 2012).

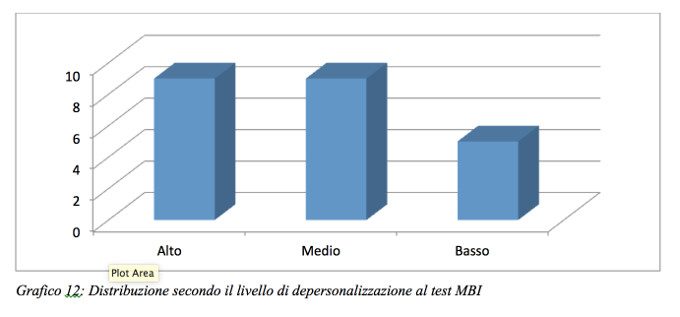

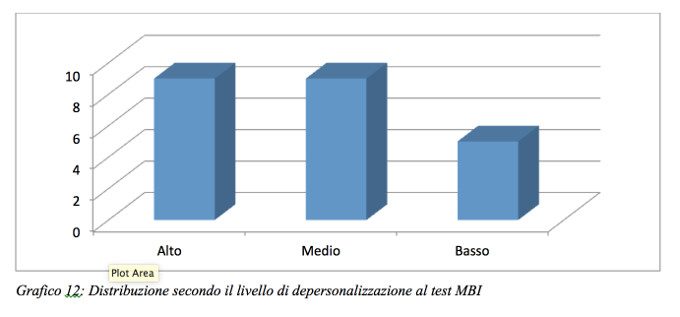

Nella casistica presente nei nostri archivi 2015 un livello di depersonalizzazione alto è stato rilevato nel 39% dei casi; un livello medio nel 39% dei casi; mentre un basso livello di depersonalizzazione nel 22% dei casi.

Grafico 12: Distribuzione secondo il livello di depersonalizzazione al test MBI

Gratificazione personale: è la dimensione autoriflessiva: il soggetto si chiede se il ruolo che ricopre è adatto alle proprie capacità. Inizia un sentimento di inadeguatezza circa la propria capacità di stare in relazione con l’altro che può condurre ad un vero e proprio verdetto di fallimento. Le conseguenze possono essere crollo di motivazione, perdita dell’autostima e depressione.

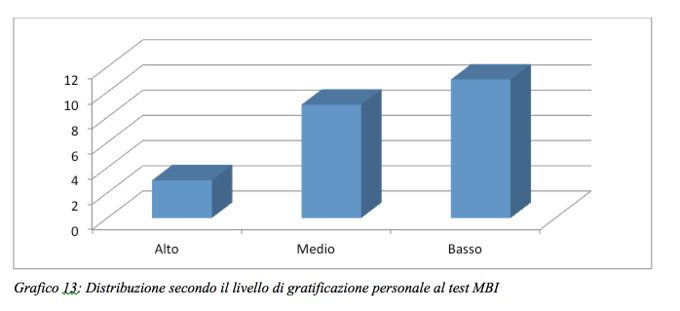

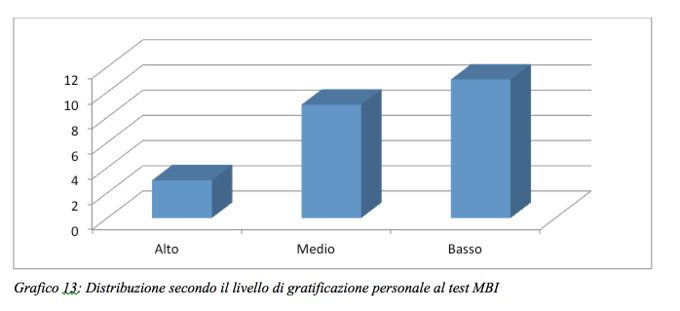

Nelle valutazioni del 2015 sono emersi questi dati in relazione alla gratificazione personale:

il 48% dei casi ha manifestato un livello di gratificazione personale BASSO;

il 39% dei casi ha manifestato un livello di gratificazione personale MEDIO;

il 13% dei casi ha manifestato un livello di gratificazione personale ALTO.

Il livello di gratificazione personale corrisponde al valore inversamente proporzionale rispetto al rischio burnout.

Grafico 13: Distribuzione secondo il livello di gratificazione personale al test MBI

Indicazioni al trattamento dello stress lavoro correlato

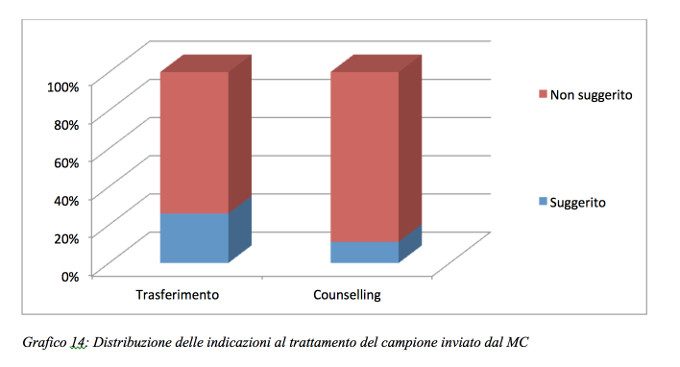

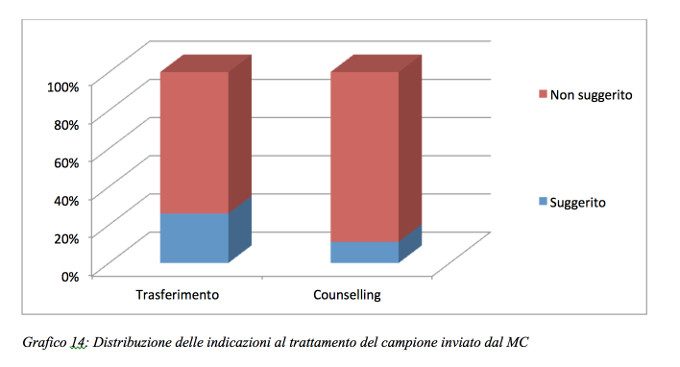

In relazione al campione delle visite a richiesta si è proceduto con una analisi secondo indicazioni al trattamento.

Nello specifico, in un processo di analisi delle singole casistiche, è stata registrata come si vede dal seguente grafico l’indicazione di trasferimento di posizione lavorativa o il suggerimento ad un percorso di counselling psicologico. I dati riportano una percentuale di suggerimento evidentemente bassa.

Grafico 14: Distribuzione delle indicazioni al trattamento del campione inviato dal MC

Conclusioni

Dall’analisi dei dati emerge una maggior presenza del genere femminile, con una percentuale più elevata di prime visite nel range d’età che va dai 21 ai 40 anni, mentre si riscontra la maggior percentuale di visite a richiesta nella fascia d’età che va dai 41 ai 60 anni, da sottolineare inoltre un aumento significativo delle visite a richiesta specialmente nella fascia d’età che va dai 51 ai 60 anni.

I dati mostrano che tra le visite a richiesta, la maggior parte sono a richiesta del lavoratore, seguite da quelle a richiesta del medico competente, mentre in percentuale decisamente inferiore quelle a richiesta del responsabile dell’U.O. Nella maggior parte dei casi il soggetto ha avuto bisogno di un massimo di due colloqui.

Questi dati sottolineano l’importanza di una gestione organizzativa del personale differenziata.

Il test maggiormente utilizzato, è la Resilience Scale. La maggior parte dei soggetti a cui è stato somministrato questo test riporta buone capacità di resilienza. Un altro test utilizzato spesso nel 2015 è l’MBI; le analisi dei dati relative alle sottoscale dell’MBI sono state precise: la maggioranza dei soggetti ha manifestato alto esaurimento emotivo, alta depersonalizzazione e bassi livelli di gratificazione personale.

L’ analisi delle singole casistiche, ha riportato una percentuale d’indicazione di trasferimento di posizione lavorativa e la necessità di un percorso di counselling psicologico bassa, fattore che dispone a favore dell’efficacia del processo in relazione all’indice UP-DOWN SIZING proposto dalla Regione Lombardia c.c. 18/11/2010.

La lettura dei dati permette di evidenziare come l’esistenza di un servizio di integrazione alla sorveglianza sanitaria, a supporto dell’attività del Medico Competente, consenta ai dipendenti di richiedere un supporto psicologico e al Medico Competente di indicare/prescrivere una valutazione SLC così da prevenire eventuali ritorsioni negative individuali ed organizzative. I dati riportano che degli interventi erogati analizzati (il 37% del campione totale) il 74% ha avuto una remissione sintomatica con un numero medio di 2 colloqui, contro il 26% dei casi non gestiti che continua a perpetrare l’indicatore Up Down Sizing (spostamenti interni del personale dipendente).

Le ipotesi ragionevoli per futuri sviluppi sono la possibilità di rendere più omogenea, la somministrazione dei test: fornire una baseline comune a tutti i soggetti (o perlomeno ai neoassunti) consentendo l’analisi del rischio di stress lavoro correlato in un percorso di costante monitoraggio.

Tale approccio è già stato in buona parte concretizzato dalla somministrazione diffusa del test Resilience Scale di Wagnild e Young.