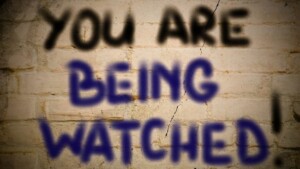

Muovendoci lasciamo una scia. Una volta era di un profumo, oggi vi si aggiunge un alone di dati, un corteo che non ci abbandona mai, dal risveglio al sonno notturno. Un furto di privacy h24.

L’editorialista Noonan del Wall Street Journal ha osservato:

La privacy è legata alla nostra persona. Ha a che fare con aspetti intimi — i meccanismi della nostra testa e del nostro cuore, il funzionamento della nostra mente — e il confine tra queste cose e il mondo esterno (2013).

Eppure, muovendoci, lasciamo una scia. Una volta era di un profumo; oggi vi si aggiunge un alone di dati. Un corteo – quello dei dati – che non ci abbandona mai, dal risveglio al sonno notturno. Un furto di privacy h24.

Bersagli sono molte categorie di soggetti, tra cui tipicamente consumatori, lavoratori, giovani. Nel 2018, le società statunitensi hanno speso circa 19 miliardi di dollari per acquisire e interpretare i dati riguardanti i consumatori (Matsakis, 2019).

I dati sono dual use:

- cibo per nutrire algoritmi;

- cibo per mercato, politica, sanità, sicurezza, giustizia, ambiente, ricerca, ecc.

Le piattaforme social forniscono un enorme patrimonio di dati personali. Ci si può illudere che esse siano gratuite. Invece è uno scambio in cui stiamo cedendo informazioni personali a fronte di un servizio. Com’è noto, “se non stai pagando un prodotto, tu sei il prodotto”. Non esistono free lunch: quanto viene postato sui social viene usato per profilare e mirare efficientemente la messaggistica. Se possiamo considerare positiva la circostanza di ricevere annunci e post che ci interessano, è pure necessario essere consapevoli di cosa viene fatto dei nostri dati personali e controllare il loro uso tramite un consenso informato (Rossi, 2019).

Ma ecco che sorge un’altra questione spinosa. Verosimilmente è stato accordato il proprio consenso nel momento della sottoscrizione delle condizioni di un’app. Ma le informative sono complesse. Secondo il Time, per leggere tutte le condizioni d’uso, una persona impiegherebbe 76 ore ogni anno. Il New York Times, quando ne lesse 150, le definì “un disastro incomprensibile” (Pasley, 2020).

L’agenda della nostra giornata trasmuta per le tecno-compagnie in agenda di dati.

Al risveglio, se si vorrà dare un’occhiata alle notizie tramite smartphone, rimarranno le tracce.E se ci accadesse quanto capitato a Geoffrey Fowler del Washington Post? Ha scoperto che il suo iPhone inviava dati a decine di aziende nella notte (Pasley, 2020).

Per andare al lavoro, ci serviamo di ciò che il New York Times ha definito “essenzialmente uno smartphone con le ruote”. Chi noleggia d’abitudine un’automobile di una compagnia tramite app sarà accolto, entrato nell’autoveicolo, dal proprio genere di musica preferito trasmesso dalla radio. E’ stato registrato in memoria e appreso. Il tragitto all’interno di una comfort area. E’ stata acquistata un’auto? Essa è in grado di registrare il peso dell’automobilista, il numero dei passeggeri, la velocità, le strade percorse.

Arrivati in ufficio, ecco cosa può accadere… Avere la brutta sorpresa di essere stati profilati dall’azienda o, quanto meno, essere assaliti dal timore di subire la sorte di dipendenti di altre società. Ad esempio, della catena di moda svedese H&M, con i suoi presunti trattamenti illeciti dei dati dei propri dipendenti per mezzo di registrazioni occulte. Le informazioni riguarderebbero aspetti sensibili, quali la loro salute e vita privata.Come afferma l’Autorità per la protezione dei dati di Amburgo – che ha avviato un procedimento nei confronti dell’H&M- l’ampiezza quantitativa e qualitativa del trattamento dei dati dei dipendenti, accessibili a tutto il management dell’azienda, mostra una profilazione completa dei dipendenti non paragonabile a nessun’altra (Domenici, 2020).

Questo orrifico episodio ci fa tornare in mente un altro scabroso scandalo, anch’esso recente. Secondo quanto riportato dal The Wall Street Journal (Copeland, 2019), negli USA il progetto Nightingale ha visto Google, insieme all’operatore sanitario Ascension, raccogliere segretamente i dati (di laboratorio, diagnosi mediche, con nomi e data di nascita) relativi a cartelle cliniche di pazienti appartenenti a 21 Stati USA: la loro storia medica al completo. Il ruolo di Google è stato mettere a disposizione sistemi di intelligenza artificiale (IA) per leggere le cartelle cliniche elettroniche e identificare più rapidamente le condizioni di un paziente. Scopo, una più efficiente interoperabilità nella rete ospedaliera americana (Porro, 2019). Efficienza vs. etica.

Raccogliamo poi lo sfogo di un’amica il cui figlio sta facendo domanda di iscrizione a università statunitensi, ma – dice – la email etiquette potrebbe venire controllata. Infatti, le università americane si servono dei dati, quali la quantità di tempo su cui resta aperta una mail e i link cliccati, per valutare il grado di motivazione del candidato (Pasley, 2020).

Uno studio della Northeastern University (Renet al., 2019) – il più esteso sulle smart tv – ha illustrato che i televisori connessi di nuova generazione trasferiscono dati sensibili degli utenti a società quali Google, Netflix e Facebook, persino se non abbonati ad alcun servizio. Nel caso di Netflix, i dati vengono spediti anche quando l’app non è attiva. Fra le numerose implicazioni: terze parti sono in grado di sapere se siamo in casa; in base alle preferenze scelte sul dispositivo, possiamo essere targettizzati con una pubblicità mirata ed efficace. Sicurezza e privacy a rischio, dal quale pure l’FBI allerta per evitare di essere spiati e finire nella rete della cyber criminalità (Lavalle, 2019).

La violazione dei dati personali è una neverending story: ToTok, simile nel nome alla più famosa (e altrettanto problematica) TikTok, sebbene si presentasse come app di messaggistica – tipo WhatsApp, Telegram, Signal –sarebbe stato strumento di spionaggio gestito dal Governo degli Emirati Arabi Uniti (Rijtano, 2019). Dietro l’app, infatti, ci sarebbe stata Pax AI, azienda specializzata nel data mining, a sua volta, collegata a DarkMatter, una società di Abu Dhabi che si occupa di white e black hacking: protegge la sicurezza e la privacy dei suoi clienti, mentre spia i loro concorrenti. ToTok era uno strumento di sorveglianza molto efficace, perché tracciava conversazioni, spostamenti, contatti, appuntamenti, il suono registrato dal microfono e le immagini catturate dalla fotocamera dello smartphone su cui era installato. In febbraio Google l’ha rimosso (Martiradonna, 2020; HDBLOG.it, 2020).

Il tema della privacy – la tutela di informazioni personali, il valore e il costo di tale tutela – può rientrare nel solco nella letteratura dell’economia dell’informazione. In tale prospettiva, la privacy non ha esclusivamente valenza giuridica, ma anche economica.

Nel 2010 Zuckerberg aveva tentato di abbassare il valore e il costo della tutela dei dati personali, affermando che

Ormai gli utenti condividono senza problemi le informazioni personali online. Le norme sociali cambiano nel tempo. E così è anche per la privacy (Bruno, 2010).

E’ il tecno-capitalista che parlava poiché massimizzare i suoi profitti significa sfruttare l’innata socialità dell’uomo e la tendenza alla esposizione di sé; i dati personali (cioè la vita degli utenti) si trasformano in risorsa economica da estrarre attraverso la surrettizia offerta di una vita user-fliendly, attraverso la retorica della condivisione e la componente ludica, il make-up di tale strategia. Ma sbagliava Zuckerberg nelle sue dichiarazioni pro condivisione a tutto tondo: tale (artato) ottimismo sperimenta oggi un totale viraggio a favore della privacy. Ed egli stesso – a meno di dieci anni da quella dichiarazione forte – attua un viraggio della medesima portata, quando nel 2019 a San Jose, dal palco del Congresso F8 (la Convention per gli sviluppatori dei social network), si è presentato con una scritta altrettanto forte e a lettere cubitali “The future is private” (Fiocca, 2019). Tra i buoni propositi a favore della privacy per il 2020 c’è la tutela degli utenti introducendo la nuova funzione “Off-Facebook Activity”, che consente di limitare le informazioni condivise con siti e app di terze parti. A conferma del new deal, in gennaio Facebook ha festeggiato il “Data Privacy Day” per rassicurare i cittadini quanto il tecno-capitalismo sia sensibile al tema della privacy. Peccato che ai festeggiamenti si sia messo di traverso lo scandalo Avast, antivirus disponibile gratuitamente sul mercato: l’applicazione memorizzava le attività degli utenti registrati e trasferiva le informazioni a una società controllata di Avast -la Jumpshot – per confezionare pacchetti di dati da vendere a colossi quali Google, Yelp, Microsoft, McKinsey, Pepsi, Home Depot e varie società di marketing. Naturalmente, per potenziare i canali di vendita, profilare il mercato in segmenti, ottimizzare i servizi, ecc. (D’Elia, 2020).

Particolarmente incisivo, anche per l’autorevolezza dei soggetti – il Vaticano, promotore della “Rome Call for AI Etichs” e la Commissione europea, con la pubblicazione in febbraio del Libro Bianco sull’Intelligenza artificiale – l’attuale battage sull’etica e l’allineamento ai valori umani della IA.

Termini come Trasparency, Inclusion, Accountability, Responsability, Impartiality, Reliability, Security, Privacy, devono diventare patrimonio di tutti e non solo degli esperti dell’etica dell’Intelligenza Artificiale (V. Paglia in RaiNews, 2020).

Aspetti fondanti, questi, di fronte a pratiche sempre più pervasive della IA, tra cui il tanto dibattuto riconoscimento facciale – ormai diffusamente applicato, anche in paesi con governi non autoritari.

La UE già possiede normative adeguate sulla privacy: il Regolamento generale sulla protezione dei dati (Gdpr – Regolamento UE 2016/679) ha consentito di mettere la protezione dei dati al centro del dibattito anche per l’IA (art. 22). Preoccupazione e indicazioni inerenti aspetti etici sono emerse nel giugno 2019 pure da un rapporto del Gruppo di alto livello della Commissione europea sulla IA: l’UE dovrebbe regolamentare pratiche invasive quali identificazione biometrica (come il riconoscimento facciale), uso di sistemi autonomi di armi letali (come i robot militari), profilazione dei bambini. Poco dopo, appena insediata, la Presidente della Commissione fissò tra le sue priorità la regolamentazione della IA in Europa. Le proposte sono contenute nel Libro Bianco sull’intelligenza artificiale e una strategia europea sui dati. La Commissione punta a un approccio “umanocentrico”, secondo cui i sistemi di IA vengano utilizzati in modo da rispettare le leggi UE e i diritti fondamentali. L’identificazione biometrica in remoto e altri sistemi di IA ad alto rischio sono consentiti solo per motivi di “sostanziale interesse pubblico” e dovranno essere “trasparenti, tracciabili e garantire il controllo umano in settori sensibili come salute, polizia e trasporti”. La strategia sui dati intende creare un mercato unico dei dati in cui i dati personali e non, (inclusi quelli confidenziali e sensibili), siano sicuri e in cui imprese e pubbliche amministrazioni possano avere accesso per creare e innovare.

Siamo su un crinale, dove si interfacciano esigenze talora confliggenti: progresso scientifico e valori etici, fra cui il diritto alla privacy. Esempio sotto gli occhi di tutti è la tecnologia della IA a contrasto del Covid-19. Oggi tale esempio può rappresentare l’icona della relazione fra l’esigenza e l’emergenza di tutelare la salute collettiva e la tutela della sfera privata. Un video di Global China fa vedere un drone che invita un’anziana donna tibetana a indossare la mascherina per proteggersi dal coronavirus (Marino, 2020). L’utilizzo di tale drone pregiudica la privacy, attraverso il riconoscimento facciale, il tracciamento, la georeferenziazione, la profilazione. Da qui il trade-off, poiché gli algoritmi – nel profilare i soggetti colpiti – permettono di individuare i soggetti che avranno una maggiore probabilità di essere prossime vittime dell’epidemia, mettendo in grado i sanitari di intervenire preventivamente e comprendere i comportamenti del virus per combatterlo più efficacemente.

Una predittività salvifica per la quale val la pena cedere pezzi di privacy.

Questa è la prima pandemia con cui la IA si confronta. E’ un caso pilota. Si tratta di segnare il confine tra tutela sociale contro rischi sistemici e tutela individuale alla privacy. Il Libro Bianco ne fornisce una chiave di lettura per l’Europa.